1.人工智能相关概念

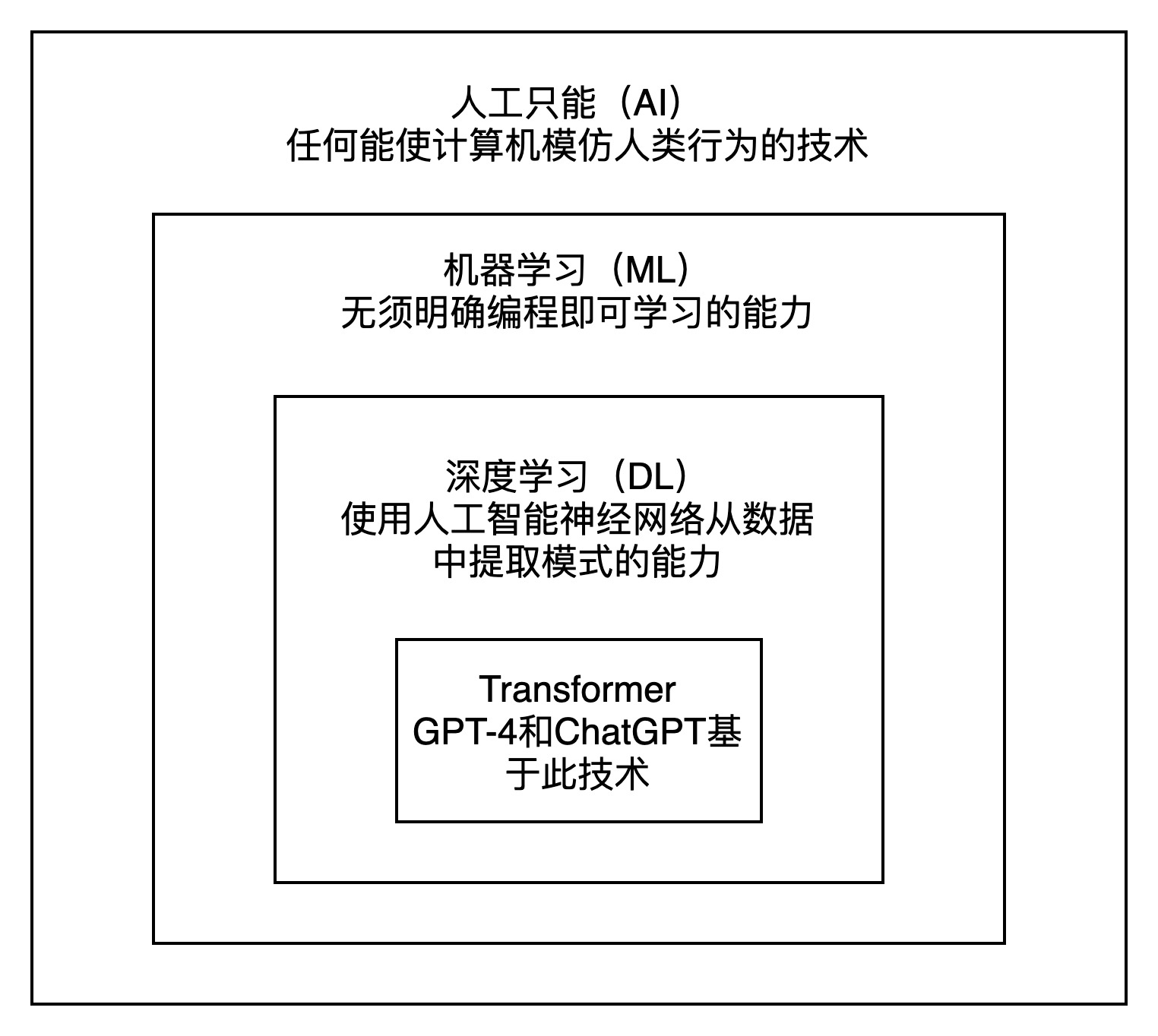

从AI到Transformer的嵌套技术集合如下图所示:

AI有不同的定义,但有一点已达成共识,AI是一类计算机系统,它能够执行通常由人类只能才能完成的任务。

NLP是AI的一个子领域,专注于使计算机能够处理、解释和生成人累语言。现代NLP解决方案基于ML算法。NLP的目标是让计算机能够处理自然语言文本。

机器学习是AI的一个子集,在ML中,我们不试图直接实现AI系统使用的决策规则,而是试图开发算法,使系统能够通过示例自己学习。

深度学习是机器学习的一个分支,专注于受大脑结构启发的算法。这些算法被称为神经网络。它们可以处理大量的数据,并且在图像识别、语音识别、及NLP等任务上表现出色。

GPT-4和ChatGPT基于一种特定的神经网络架构,即Transformer。Transformer像阅读机一样,它关注句子或段落的不同部分,以理解其上下文并产生连贯的回答。此外它还可以理解句子中的单词顺序和上下文意思。这使得Transformer在语言翻译、问题回答、文本生成等任务中非常有效。

2.Transformer

Transformer架构彻底改变了NLP领域,主要是因为它能哦股有效地解决NLP模型存在的一个关键问题:很难处理长文本序列并标记住其上下文。换句话说,RNN在处理长文本序列时容易忘记上下文,也就是臭名昭著的“灾难性遗忘问题”。Transformer具备高效处理和编码上下文的能力。

这场革命的核心支柱是注意力机制,这是一个简单又强大的机制,模型不再将文本序列中的所有词视为同等重要,而是在任务的每个步骤中关注最相关的词。交叉注意力和自注意力是基于注意力机制的两个架构模块。

3.NLP技术演变

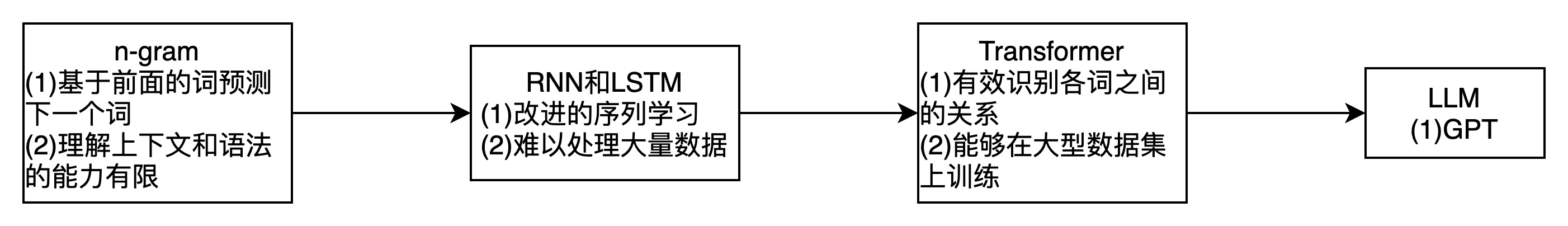

如下图所示:

LLM是一类试图完成文本生成任务的ML模型。

4.GPT模型

GPT全称Generative Pre-trained Transformer,生成式预训练Transformer。

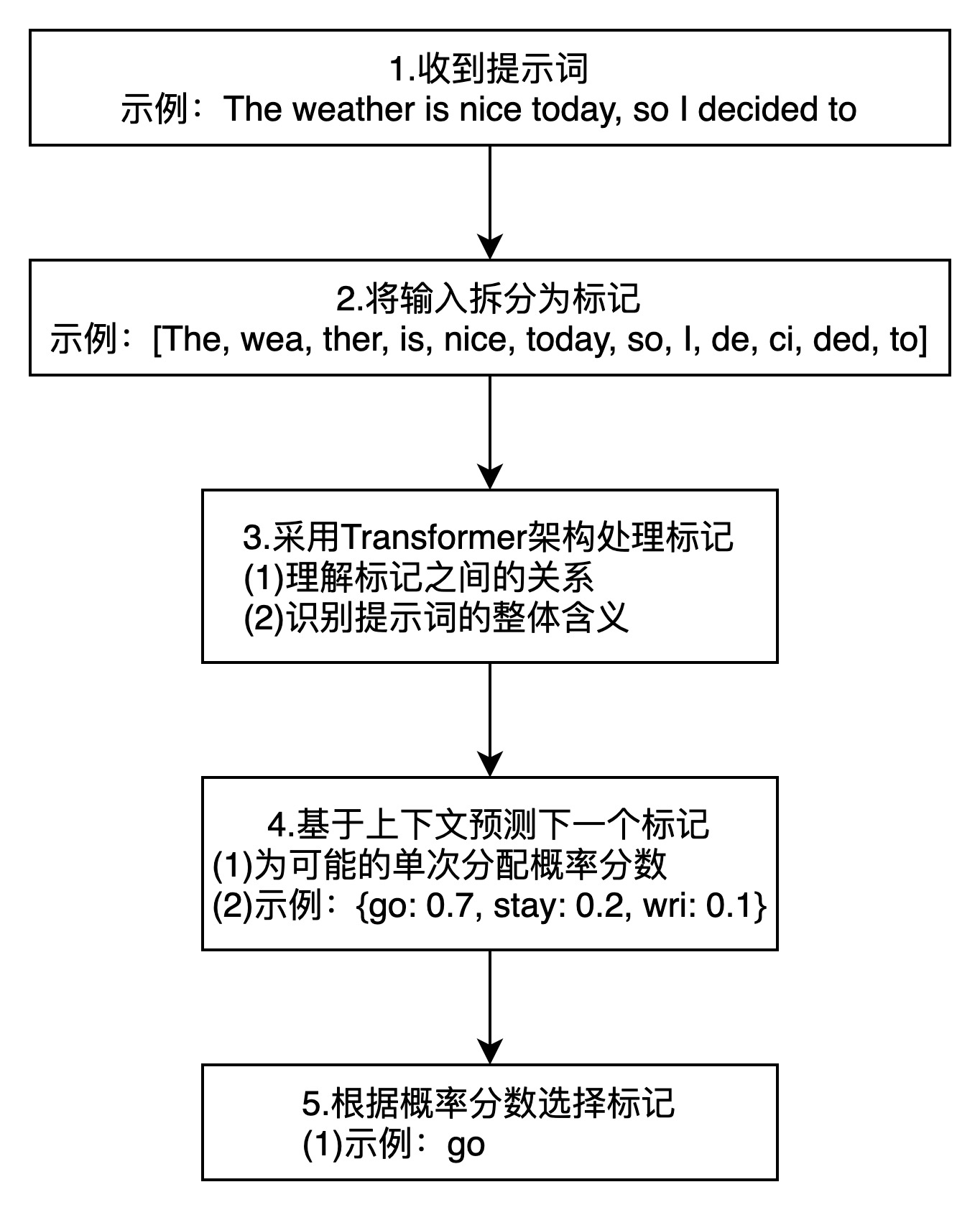

GPT模型的标记化和预测过程如下图所示:

重复步骤4和步骤5,直到形成完整的句子。